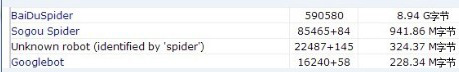

BaiDuSpider百度蜘蛛占用流量,robots.txt設置注:以下BaiDuSpider等于百度蜘蛛、Googlebot等于google蜘蛛、Sogou Spider等于搜狗蜘蛛 一、問題因某些原因,搜索引擎蜘蛛抓取網站占用很大流量,如圖:網站訪問日志也可看見很多蜘蛛爬行記錄。

二、認識、學習我們知道,搜索引擎都遵守互聯網robots協議,可通過robots.txt來進行限制。先對robots.txt一些實例說明,然后根據上面網站情況進行規則設置,通過上面截圖可以看出BaiDuSpider占用流量非常大,首先在網站跟目錄下面建立一個robots.txt文件。 例1. 禁止所有搜索引擎訪問網站的任何部分 User-agent: * Disallow: / 例2. 允許所有的robot訪問 (或者也可以建一個空文件 “/robots.txt” file) User-agent: * Allow: 例3. 禁止某個搜索引擎的訪問(禁止BaiDuSpider) User-agent: BaiDuSpider Disallow: / 例4. 允許某個搜索引擎的訪問 User-agent: Baiduspider allow:/ 例5.禁止二個目錄搜索引擎訪問 User-agent: *Disallow: /admin/Disallow: /install/ 例6. 僅允許Baiduspider以及Googlebot訪問User-agent: Baiduspider Allow: /User-agent: Googlebot Allow: / User-agent: * Disallow: /例7. 禁止百度搜索引擎抓取你網站上的所有圖片User-agent: Baiduspider Disallow: /*.jpg$ Disallow: /*.jpeg$ Disallow: /*.gif$ Disallow: /*.png$ Disallow: /*.bmp$三、 問題解決(規則設置)根據以上實例,經過分析網站日志,主要是百度抓取圖片占用了流量,他還有兩個目錄也不希望搜索引擎抓取,設置規則如下解決:User-agent: *Disallow: /admin/Disallow: /install/User-agent: Baiduspider Disallow: /*.jpg$ Disallow: /*.jpeg$ Disallow: /*.gif$ Disallow: /*.png$ Disallow: /*.bmp$因為搜索引擎索引數據庫的更新需要時間。雖然蜘蛛已經停止訪問您網站上的網頁,但百度搜索引擎數據庫中已經建立的網頁索引信息,可能需要數月時間才會清除。也就是說設置限制之后日志還會看見蜘蛛爬行,逐漸會降低抓取直到完全生效,這種問題會持續一段時間。如果您需要盡快屏蔽,訪問以下幫助中心進行投訴,搜索引擎就會較快處理。 四、 知識加強為更詳細了解蜘蛛爬行原理和robots.txt寫法,建議詳細閱讀以下標準資料: BaiDuSpider幫助中心 http://www.baidu.com/search/spider.html Googlebot幫助中心 http://support.google.com/webmasters/bin/answer.py?hl=zh-Hans&answer=182072 Sogou Spider幫助中心 http://www.sogou.com/docs/help/webmasters.htm Robots.txt 詳細介紹:http://baike.baidu.com/view/1280732.htm baidu提供標準robots.txt寫法:http://www.baidu.com/search/robots.html

|

|||

| >> 相關文章 | |||

浙公網安備 33048302000166號

浙公網安備 33048302000166號